[미디어스 김홍열 칼럼] 최근 성균관대학교 교육개발센터에서 흥미로운 보도자료를 발표했다. 지난 1학기 동안 생성형 AI를 학습에 활용한 경험이 있는 재학생 219명을 대상으로 한 설문조사를 했고 그 결과를 발표했다. 조사 결과 설문조사에 참여한 학생 대부분(86.8%)이 챗GPT 등 생성형 AI 사용을 통해 학습의 효율성이 좋아졌냐는 질문에 ‘예’라고 응답했다. ‘아니오’라는 응답은 불과 10%에 그쳤다. 설문에 응답한 학생들 가운데 56.2%는 챗GPT가 등장하기 전에는 과제 수행에 어려움이 있었다고 응답했고 83.6%는 ‘과제 수행 시 교수님, 조교, 친구 등의 도움이 있기를 희망했다고 응답해 생성형 AI가 어느 정도 과제 수행에 도움을 주었다고 볼 수 있다.

![[AP 연합뉴스 자료사진]](https://cdn.mediaus.co.kr/news/photo/202309/306420_208207_4420.jpg)

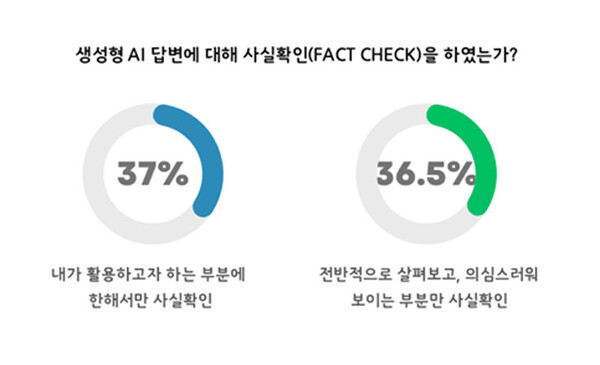

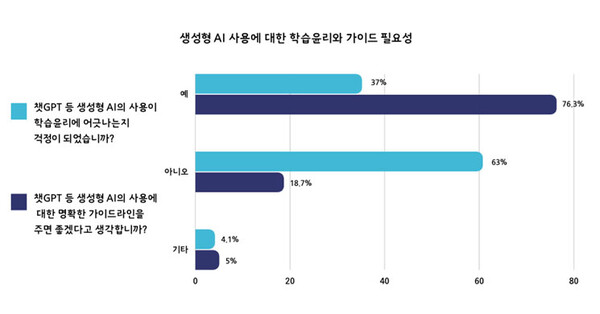

사실 위 설문조사 결과에 상관없이 AI가 과제 수행에 어느 정도 도움이 될 수 있다는 것은 충분히 예측할 수 있는 일이었다. 문제는 챗GPT 열풍이 불 때 이슈가 되었던 생성형 AI 부작용에 대한 우려였다. 하나는 AI가 내놓은 답이 사실이 아닐 가능성이 있다는 것이었고 다른 하나는 AI 산출물 이용하는 것에 대한 윤리적 문제였다. 보도자료에 따르면 설문조사에 응답한 학생의 90% 이상이 생성형 AI가 내놓은 답변에 대해 팩트 체크를 했다고 답했다. 윤리 문제에 대한 설문, 즉 챗GPT 등 생성형 AI의 사용이 학습윤리에 어긋나는지 우려하냐는 질문에는 ‘아니오’라는 응답비율이 63%로 ‘예’ 응답비율(37%)보다 약 2배 정도 많은 것으로 나타났다.

대부분의 학생이 팩트 체크를 했다는 것은 이제 더 이상 AI 산출물에 대한 맹목적 신뢰는 없다는 것을 의미한다. 챗GPT 열풍 초기 AI가 내놓은 답변의 사실 여부에 관한 사회적 우려가 오히려 팩트체크의 필요성을 확산시켰다고 볼 수 있다. 그러나 설문조사 결과에서 팩트체크 여부보다 더 중요한 것은 AI 산출물 이용에 대한 응답자들의 윤리적 태도다. 응답 학생의 63%가 생성형 AI의 사용이 학습윤리에 어긋나지 않는다고 대답했다. 응답자의 대부분이 동의한 것은 아니지만 63%라는 수치는 AI 활용에 많은 학생들이 개방적이라는 것을 의미한다. 같은 질문의 설문조사가 매년 수행된다면 이 수치는 더 올라갈 가능성이 크다.

비단 AI뿐만이 아니라 새로운 기술이 교육 학습에 도입될 때는 논란이 계속 있어 왔다. 대표적 사례가 전자계산기다. 전자계산기를 일반 사무 용도에 이용하는 경우 별 문제가 없었지만 수학·산수시간에 계산을 위해 사용하는 것에 대해서는 반대가 많았다. 최종적으로 교육부가 초·중·고교 수학 수업시간에 계산기 사용을 허용하기로 했지만 그 과정까지는 찬반 논란이 많았다. 교육부의 이런 결정의 배경은 중요한 것은 사칙연산 능력이 아니라 수학적 개념에 대한 이해라는 판단에서 나왔다. 기술 또는 기술의 결과물을 이용하는 것은 실질적 도움 여부에 달려있는 것이지 사용에 따른 편의성이 윤리적 태도로 이어질 필요가 없다는 것이다.

이와 유사한 사례는 인터넷 시절 초기에도 있었다. 지금은 이미 흘러가버린 옛이야기가 되었지만 초기 인터넷이 보편화될 때 인터넷 검색의 결과물이 ‘도용’될 수 있다는 우려가 많이 있었다. 학생들이 타인의 콘텐츠를 인용표시 없이 리포트 등에 이용할 수 있다면서 수기로 쓴 리포트를 요구하는 교수들도 있었고 프로그램을 활용해 도용여부를 체크하기도 했다. 이런 문제들이 지금 모두 해결된 것은 아니고 여전히 어느 정도 남아있지만 ‘도용’의 문제를 인터넷 검색 기술 탓으로 돌리는 경우는 없다. 기술과 상관없이 어느 시대에나 있는 부도덕한 행위로 간주하고 그에 맞는 법적, 사회적 제재를 받은 것으로 귀결되고 있다.

챗GPT의 경우 인터넷 검색의 결과물과 달리 AI가 질문의 내용을 이해하고 구체적으로 답을 내놓기 때문에 산출물 이용에 대한 윤리적 문제가 크게 부각되었다. 논리적 구조가 있는 리포트의 주체가 사람이 아니라 AI이기 때문에 산출물을 ‘무단’ 이용하는 것은 윤리적으로 옳지 않다는 입장이 있었다. 만약 산출물을 이용한다면 AI가 제공한 것이라는 것을 표기해야 된다는 의견도 많았다. 생성형 인공지능의 경우 이미지나 영상, 작곡까지 가능했기 때문에 산출물 이용에 대한 우려는 더 컸다. 이런 우려는 당연히 윤리적 태도 문제로 이어졌고 결과적으로 AI의 적극적 활용을 저어하게 만드는 요소로 작용하기도 했다.

이런 우려들은 여전히 존재하지만 성균관대학교 교육개발센터에서 발표한 설문조사 결과는 AI 활용에 대한 미래지향적 시사점을 던져주고 있다. 응답자의 63%가 AI의 활용을 학습윤리에 어긋나지 않는다고 판단한 것은 AI 산출물의 주체는 인간 또는 인간의 지능이고 AI는 충실한 도구라는 생각이 전제되어 있다. 좋은 답, 원하는 결과를 얻기 위해서는 질문자 스스로가 공부를 해야 한다. AI가 누구에게나 다 좋은 답을 제공하는 것은 아니다. 좋은 질문을 해야 쓸만한 답을 얻을 수 있다. AI 역시 인간이 만든 기술일 뿐이다. 잘 사용하는 것이 중요하다. 앞으로 대학 교육뿐 아니라 여러 교육 과정에 널리 사용될 필요가 있다.

☞ 네이버 뉴스스탠드에서 ‘미디어스’를 만나보세요~ 구독하기 클릭!

관련기사

- '중립적' AI는 존재할 수 있을까

- 통제된 AI의 끔찍한 시나리오

- AI와 지연된 정의의 회복

- 미래를 준비하는 또하나의 방법 'AI 리터러시'

- 디지털교과서 도입이 의미하는 것

- AI 창작물의 저작권은 누구에게 있을까

- AI 공습과 디지털 러다이트

- 지식의 범람과 지식인의 종말

- 인공지능 개발, 멈출 수 있을까

- 챗GPT가 연 지식혁명 시대, 이제는 질문의 창의성이다

- AI에게 동해 일출은 존재하지 않는다

- AI 덕에 성큼 다가온 근대 이전 세계

- AI야, 이번 주 칼럼 소재 좀 알려줘

- AI는 어떤 직업을 대체한다는 것인가

- AI 통역콜, 다시 시작된 바벨의 시대

- 2023년 IT 분야 7대 뉴스

- 회화, 사진기 그리고 AI

- AI교수와 대학의 미래

- 생성형 인공지능 시대가 요구하는 개방성

- AI, 인간의 감정을 분기점에 세우다

- 어문학과의 미래